O Robots.txt é um arquivo no formato texto, portanto pode ser facilmente editado por um aplicativo de bloco de notas (notepad do Windows, por exemplo). Ele funciona como um filtro para os robôs (robots) dos sites de busca e faz com que os programadores controlem permissões de acesso a determinadas páginas ou pastas dos sites. Em resumo, ele controla qual informação do site será ou não indexada (encontrada) nos mecanismos de busca, como o Google.

Proteção de indexação no WordPress

A configuração do robots.txt é um passo importante para que você proteja seu site WordPress. Através dele, podemos dizer para o Google e outros buscadores que não indexem diretórios críticos da instalação. Com isso, dificultamos bastante a vida de um possível atacante visto que não vai ser tão fácil eles nos atacar utilizando de pesquisas para descobrir quais plugins e temas temos instalados no FTP do nosso site.

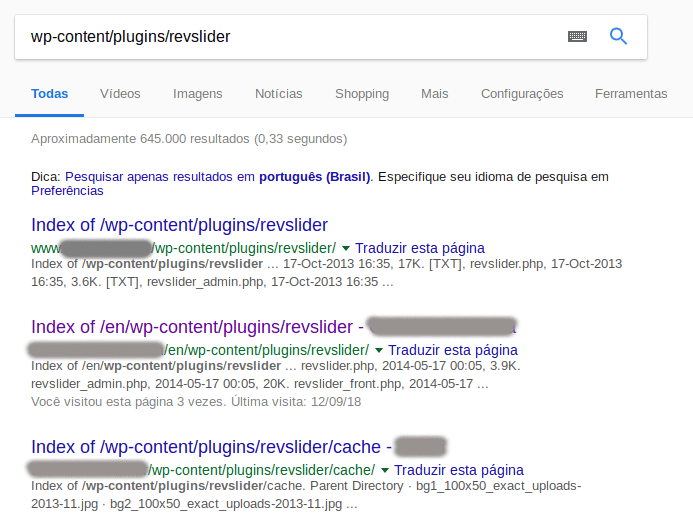

De maneira mais prática, um atacante poderia ter um resultado como o abaixo e acabar encontrando o seu site.

Como posso criar e onde devo colocar esse arquivo?

A criação do arquivo é bem simples, basta abrir um editor de texto, inserir as regras e salvar como robots.txt.

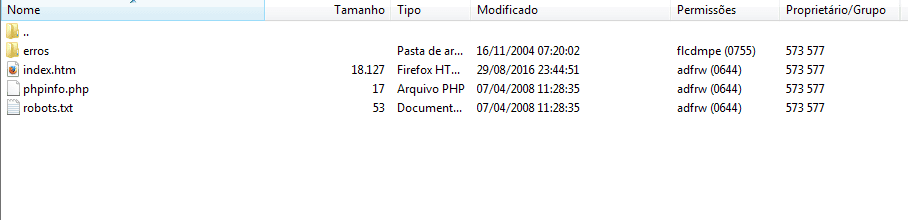

Ele deve ficar dentro do diretório raíz do FTP de seu site, dentro da pasta www.

Como posso editar o robots.txt?

A sintaxe do arquivo é bem simples. A configuração é feita através de palavras específicas que representam comandos aos robots.

Configurando o arquivo para o WordPress

Alguns conteúdos importantes do seu site não devem ser indexados pelos buscadores, sendo assim insira o conteúdo abaixo no arquivo robots.txt para evitar a indexação destes conteúdos:

User-agent: *

Disallow: /feed/

Disallow: /trackback/

Disallow: /wp-admin/

Disallow: /wp-content/

Disallow: /wp-includes/

Disallow: /xmlrpc.php

Disallow: /wp-