O Robots.txt é um arquivo no formato texto, portanto pode ser facilmente editado por um aplicativo de bloco de notas (notepad do Windows, por exemplo).

Ele funciona como um filtro para os robôs (robots) dos sites de busca e faz com que os programadores controlem permissões de acesso a determinadas páginas ou pastas dos sites. Em resumo, ele controla qual informação do site será ou não indexada (encontrada) nos mecanismos de busca, como o Google.

Como posso criar e onde devo colocar esse arquivo?

A criação do arquivo é bem simples, basta abrir um editor de texto, inserir as regras e salvar como robots.txt.

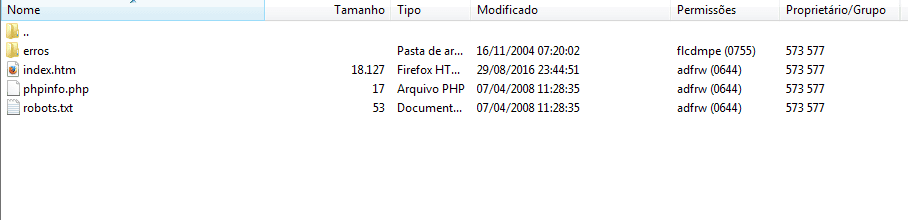

Ele deve ficar dentro do diretório raíz do FTP de seu site, dentro da pasta www.

Como posso editar o robots.txt?

A sintaxe do arquivo é bem simples. A configuração é feita através de palavras específicas que representam comandos aos robots.

Veja abaixo que tipos de comandos você pode passar através deste arquivo.

Definindo quais robots podem indexar conteúdo do seu site

O primeiro tipo de configuração é definir quais mecanismos de busca irão indexar o conteúdo do seu site.

Caso você queira que todos os mecanismos indexem seu site, não coloque esta regra ou então utilize a seguinte:

User-agent: *

Caso queira configurar um único robot você terá mais opções como, por exemplo, permitir apenas o Google, o Yahoo ou o Bing.

O conteúdo abaixo depois de um caractere # representa apenas um comentário e não faz parte da regra em si.

User-agent: Bingbot # Bing

User-agent: Slurp # Yahoo

User-agent: Googlebot # Google

User-agent: Googlebot-images # Google Imagens

User-agent: Adsbot-Google # Google Adwords

User-agent: Mediapartners-Google # Google Partners

Permitindo ou não a indexação de determinados conteúdos do seu site

Há dois comandos para este tipo de configuração.

O comando Disallow determinada quais páginas e pastas não serão indexados aos mecanismos de busca.

Já o comando Allow faz justamente o contrário. Ele deve ser usado somente em casos onde, por exemplo, você bloqueou uma pasta mas dentro dela há um arquivo que pode ser indexado. De modo simples, permitir a indexação de algo dentro de uma pasta não permitida.

Abaixo segue alguns exemplos da aplicação dos comandos:

Disallow: /blog/ # Desativa a indexação do conteúdo da pasta 'blog'

Disallow: /siste # Desativa a indexação de conteúdo, seja pasta ou arquivo, que comece com 'siste'

Disallow: secreto.php # Desativa a indexação de conteúdo da página secreto.php

Allow: /blog/home.php # A pasta blog, no exemplo acima, não será indexada, mas o conteúdo da página home.php, dentro dela, será indexado

Exemplos de arquivo robots.txt

Verificar o arquivo robots.txt de um site é um tarefa bem simples, portanto tome cuidado com as configurações realizadas. Como exemplos, seguem os robots do Google e Facebook.